Raspberry Pi Zero W

2020年 Node-RED利用履歴

HomeMadeGarbage Advent Calendar 2020 |10日目 Node-RED Advent Calendar 2020| 10日目 今年もNode-REDには大変お世話になりました。 Node-REDと私の距離感を改めて確認するべく今年の使用実績を記載いたします。 ...

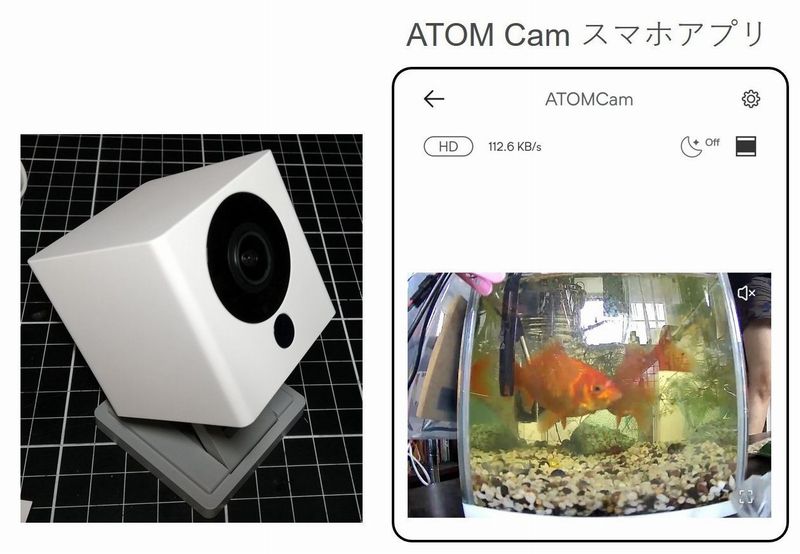

Raspberry Pi で 金魚水槽管理システム を構築

HomeMadeGarbage Advent Calendar 2020 |4日目 Raspberry Pi Advent Calendar 2020 |4日目 これまでESP32等で構成していた我が家の金魚水槽システムですが、 この度メンテナンスのし易さや拡張性の高さから制御をRaspber...

Advent Calendar / IoT / Raspberry Pi / 生活 / 金魚水槽

マリオカート ライブ を自作

先日、任天堂が『マリオカート ライブ ホームサーキット』なるSwitchソフトの発売 (2020/10/16)を発表しました。 ラジコンカーにカメラが搭載され、自宅がサーキット場になるという画期的なシステムで大変驚きました。 すごく話題になり、まだ発売前ですし9月24日現在 予約も難しい状況...

WebRTC Native Client Momo で FPVラジコンを堪能

またしてもTwitterですごいものを見つけました! 次回リリースに入れられるかな? 専用カメラ利用時の Raspberry Pi Zero からの Momo の WebRTC 配信が常用解像度 720p 30fps になりました! 遅延もちょっと縮んだきがする! pic.twitter....

ハエトリソウ捕食監視システム

Raspberry Pi Advent Calendar 2019 | 5日目長男くんがハエトリソウがハエを食べるところが見てみたいというので、ラズパイカメラで監視して捕食の瞬間を動画におさめるシステムを製作しました。また こういったIoTシステムで一番問題となる電源の確保をソーラ発電によるエコエネ...

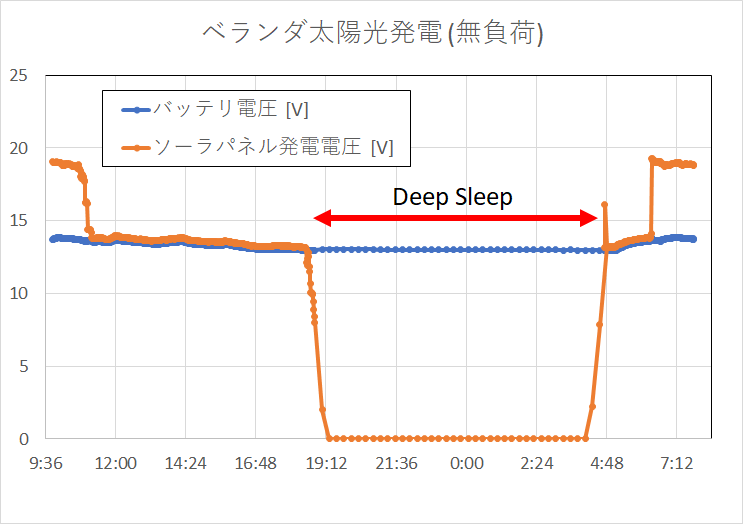

太陽光発電でタイムラプス撮影 ーベランダ太陽光発電所への道5ー

いよいよ太陽光発電を本格運用します。ここではラズパイカメラをつないでタイムラプス撮影を実施したのでご報告します。 構成 ソーラーパネルと鉛蓄電池をチャージコントローラに接続します。負荷としてラズパイカメラをつなげました。 部品 ソーラー充電コント...

micro:Maqueen 発話でラジコン! ー Alexa + Node-RED + micro:bit ー

ものすごく便利なNode-REDモジュールを見つけてしまいました。 Node-RED Alexa Home Skill Bridge というもので、仮想のAlexaデバイスを作成して発話応答をNode-REDへ返してくれます。まさにブリッジとなってAmazon Echoへの発話とNode-REDの...

AquesTalk と Node-RED と ラズパイで おしゃべりティラノくん作製

最近、長男くんがハマっているYouTubeチャンネルが以下になります。 なんか青鬼のアニメばかり見ててナレや歌が耳について耳について。。。 お母ちゃんがこのチャンネルのナレーションAquesTalkじゃね?ってことで以下のデモを使って色々しゃべると長男くんが少し怖がって、言うことを聞くことを...

IoT / Raspberry Pi / 電子工作

オムロン環境センサ と ラズパイ で ラジコンカー − GOBERNABLES de Pi −

今年のみんなのラズパイコンテストでOMRON製の環境センサの無償提供が実施されましてー 【再】応募者に、ラズパイ3、拡張基板、環境センサを無償提供します! 「みんなのラズパイコンテスト」の特別企画です。コンテストへの応募が無償提供の条件です。 ぜひ、こちらから応募ください! → h...

Raspberry Pi Zero W 単体でラジコンカー自作

前回Raspberry Pi Zero Wでサーボモータを制御してみてラズパイでなにかしらを制御するのはシンドいなぁという感想を得たのですが。。。デジタル信号制御なら問題ないだろということで、I2C入力のモータドライバでラジコン作りました。 https://homemadegarbage.com/...

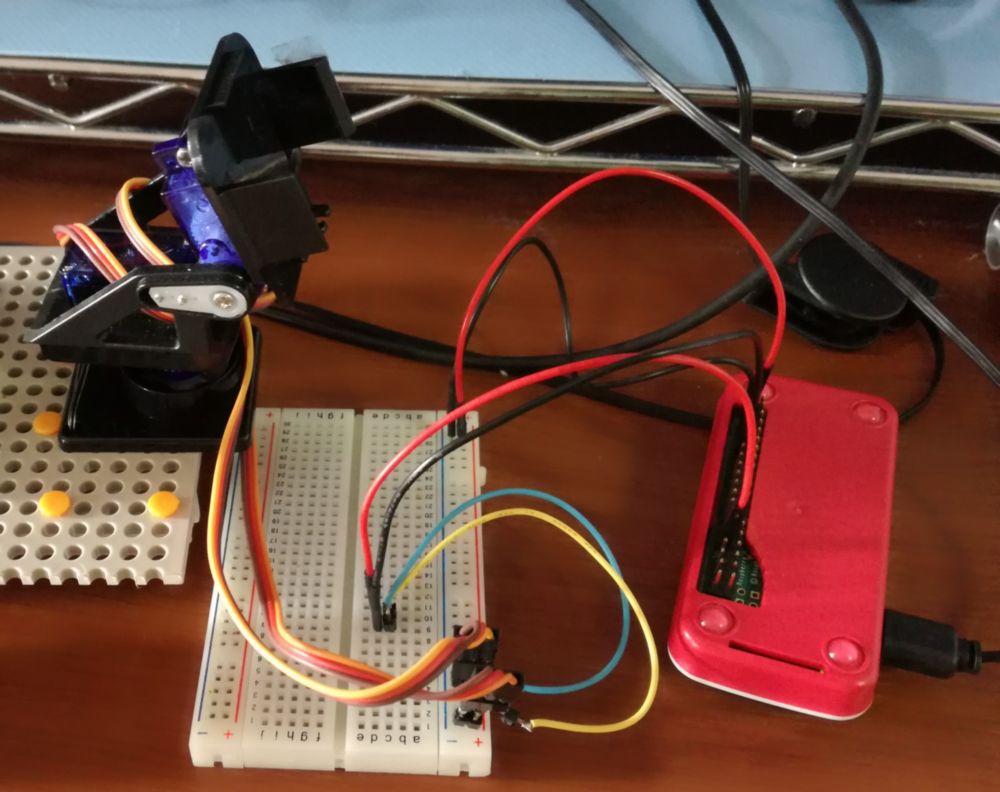

Raspberry Pi Zero W と Blynk で サーボモータ制御

Raspberry Pi Zero Wを手に入れたので、これまでなんとなく避けていたラズパイでの電子工作にトライしてみました。 ここではスマホアプリ Blynk とラズパイで2軸のカメラマウンタ(サーボモータ2個)をコントロールします。 構成 部品 Raspberry Pi Zer...