Node-RED

シン SHISEIGYO-1 Walker の開発1

先日大変素晴らしいPWMマイクロサーボを見つけまして 低価格ですがトルク・精度申し分なく 4脚ロボットを作ったりしました。バク転もできます。 https://homemadegarbage.com/robot-ptk7465/ もうサーボモータを使用した工作...

ブラシレスモータで2足歩行ロボット12 ー はじめての金属加工 ー

前回はブラシレスモータを用いた2足歩行ロボットの動作検討を実施して、現行の3自由度の足としては満足いく結果を得ることができました。 https://homemadegarbage.com/robottrip13// 家のドロイドや。かわええやろ ...

ブラシレスモータで2足歩行ロボット11 ー 動作検討3 ー

前回は足底に低反発スポンジを採用することでスムーズな足運動動作を実現することができました。 https://homemadegarbage.com/robottrip12/ 歩行もしっかり足を上げてスムーズにできるようになりました。 ...

ブラシレスモータで2足歩行ロボット10 ー 動作検討2 ー

前回はCAN通信を導入してモータトルクによるウェイトシフト検知での足踏み動作を確認しました。 https://homemadegarbage.com/robottrip11// 足踏み 念願のモータトルクからウェイトシフト検知して足切換自動化 やっとできたわ。 pic.t...

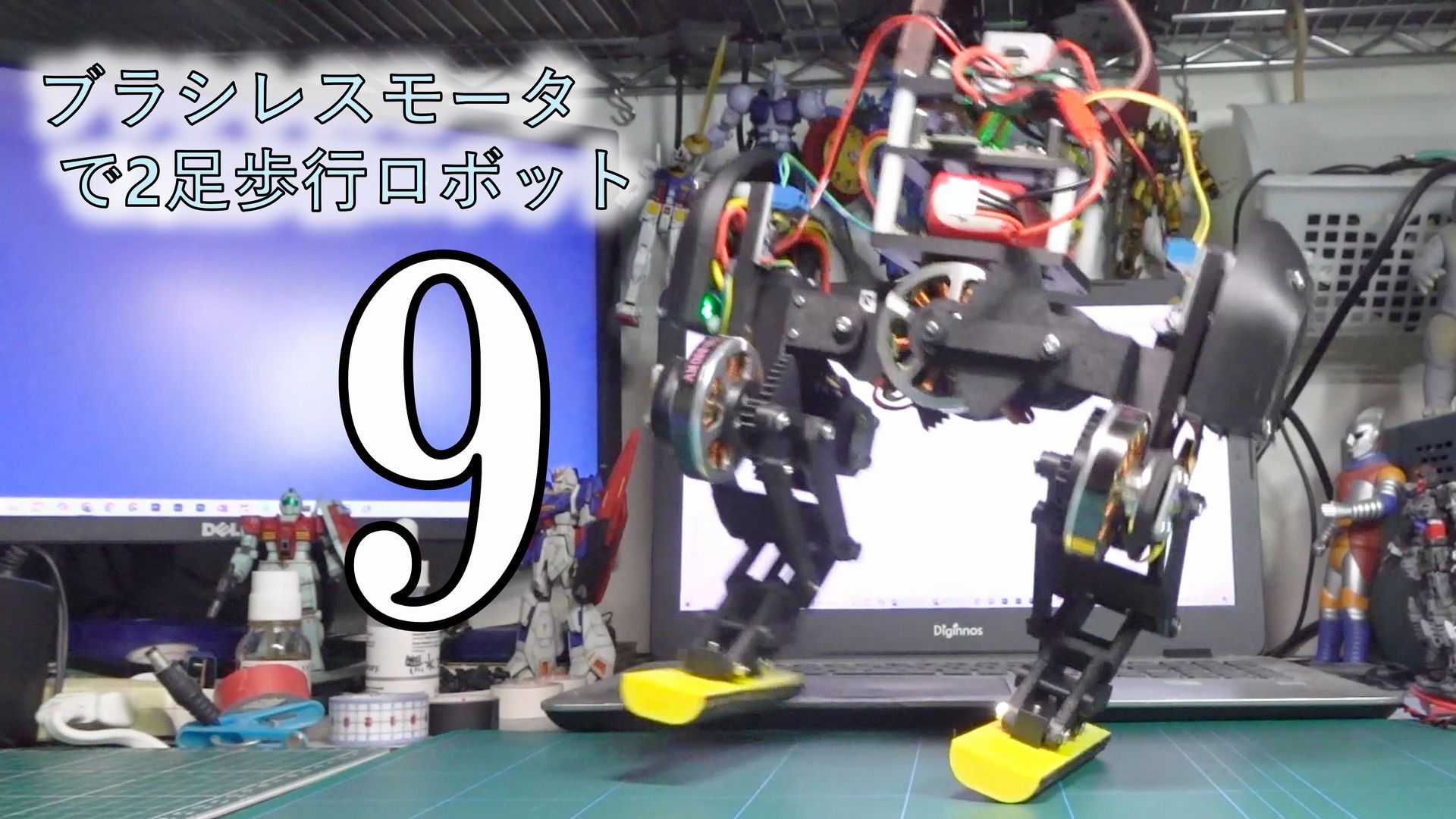

ブラシレスモータで2足歩行ロボット9 ー CAN通信導入 ー

前回は足踏みや歩行動作の検討を実施しました。 https://homemadegarbage.com/robottrip10/ 足のロール軸駆動をサーボモータからブラシレスモータにして立派な動作を実現できると思ったのですが、左右の足動作の切り替え自動化が難しかったです。 左右の...

ブラシレスモータで2足歩行ロボット8 ー 動作検討 ー

前回はロール軸の機構をサーボモータからブラシレスモータに変更してロボットを製作しました。 https://homemadegarbage.com/robottrip09// ここでは本格的にこちらの動作を検討いたします。 サイズ まず本ロボットのサイズのご紹...

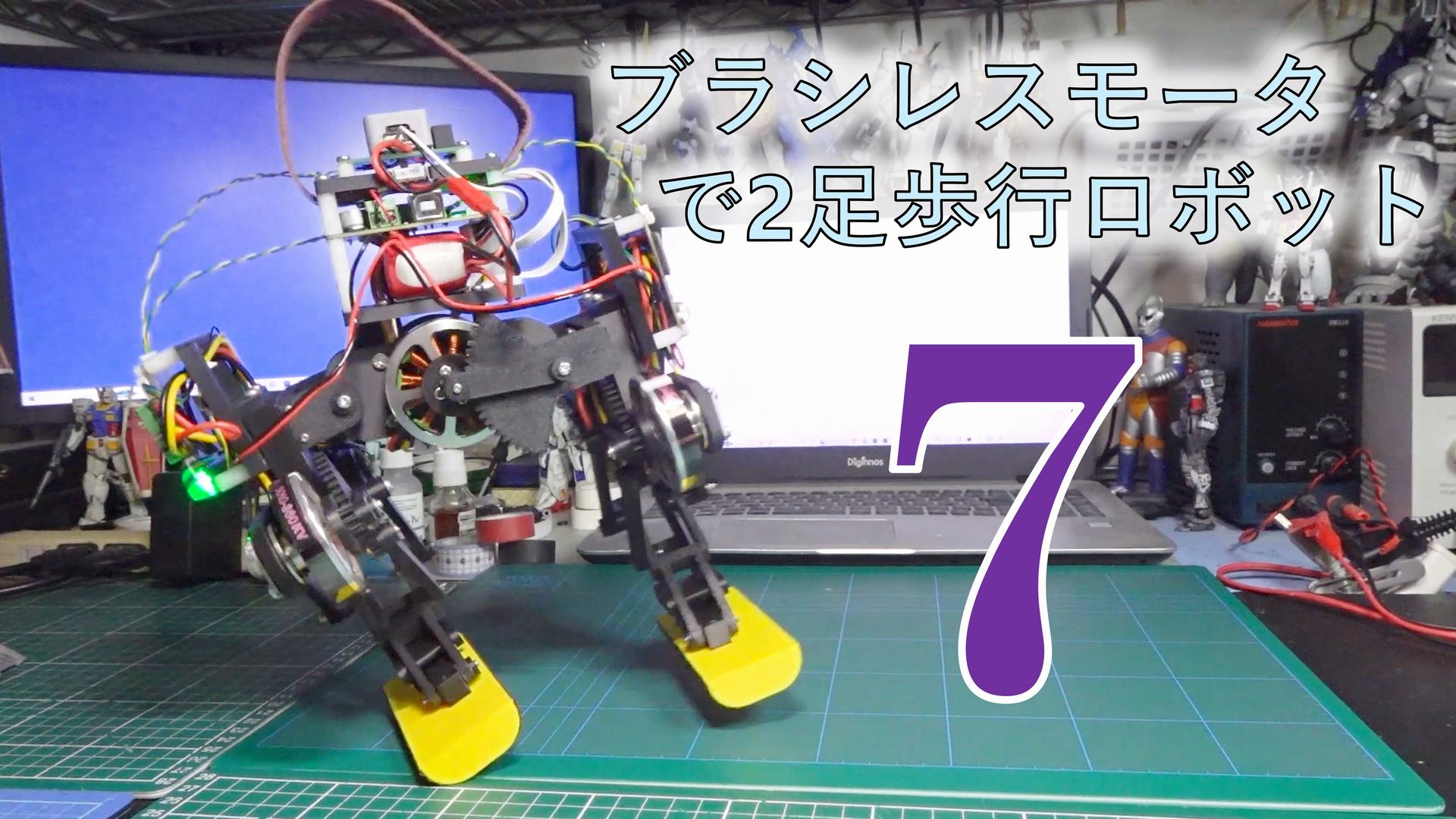

ブラシレスモータで2足歩行ロボット7 ー ロール軸BLDC導入 ー

前回は片足3自由度の2足歩行ロボットの足上げ歩行動作について検討しました。 https://homemadegarbage.com/robottrip08/ ブラシレスモータによる2軸のリンク機構の足とロール軸にサーボモータを使用しての片足 自由度3のロボットです。 歩行動作まで確認したのです...

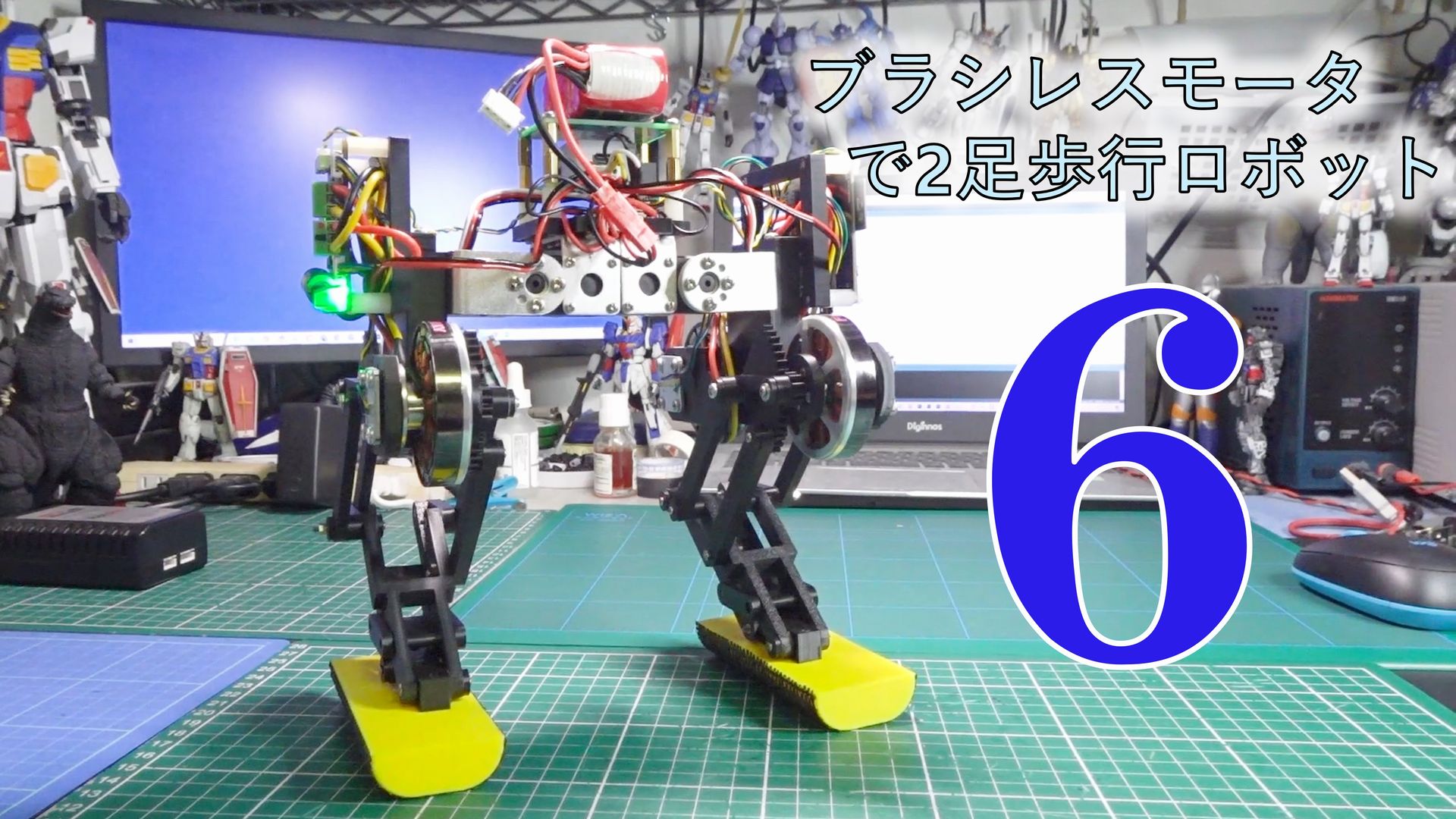

ブラシレスモータで2足歩行ロボット6 ー 足上げ歩行動作 ー

前回は2足歩行ロボット検討を再開してロール軸追加の3自由度ロボットを製作しました。 https://homemadegarbage.com/robottrip07// 基本動作を確認してなんとか歩行もできました。 次は足裏かまぼこリベンジだな pic.twitter.com...

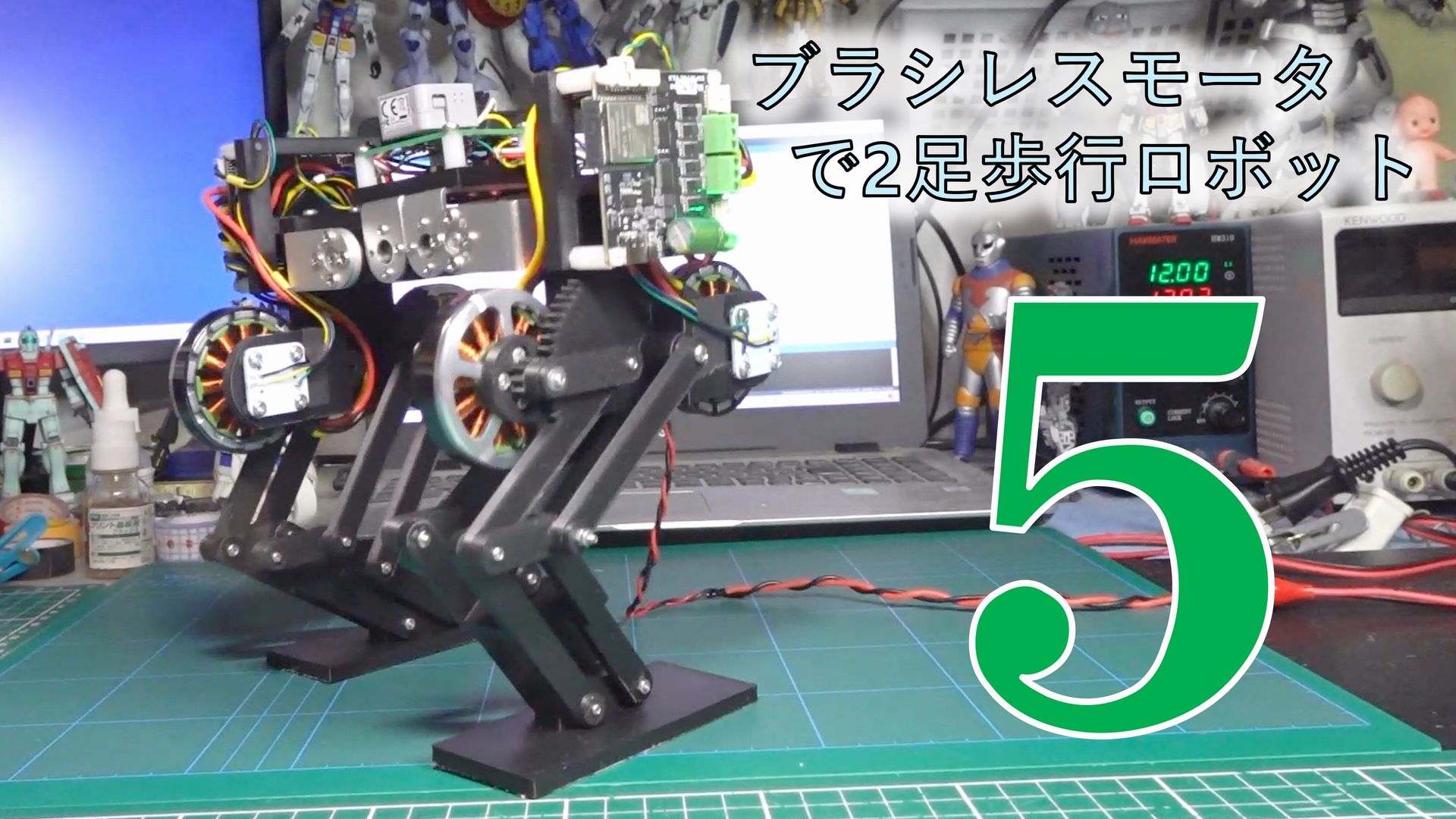

ブラシレスモータで2足歩行ロボット5 ー ロール軸導入 ー

再びブラシレスモータサーボによる2足歩行ロボットの研究に舞い戻ります。 前回はバランス動作の確認を実施しましたが、自由度2の簡易的な足のロボットでは動作にかなり制限があることが大きな実感として理解できました。 https://homemadegarbage.com/robottrip06// ...

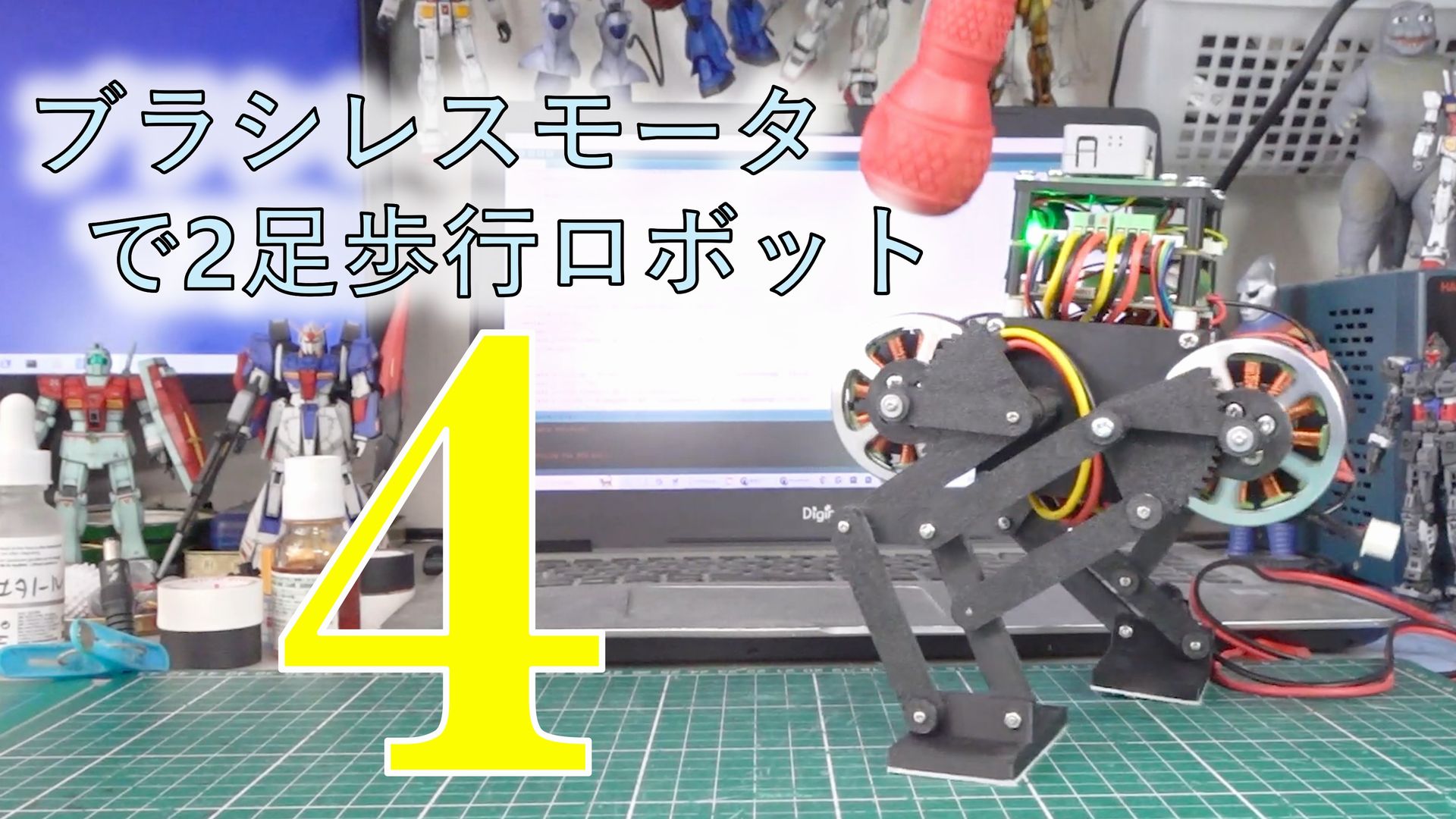

ブラシレスモータで2足歩行ロボット4 ー バランス動作 ー

前回はブラシレスモータサーボによる2足歩行ロボットの歩行やジャンプ動作を確認しました。 https://homemadegarbage.com/robottrip05/ これまでは前後に転ばないように足先をブレード状に長くして動作確認しました。 ここではブラ...

ブラシレスモータで2足歩行ロボット3 ー 基本動作 ー

前回はブラシレスモータサーボによる2足歩行ロボットを完成させました。 https://homemadegarbage.com/robottrip04/ ここでは色々動作確認実施しましたので報告いたします。 初期動作確認 以下は足の座標をPS4コントロー...

7重倒立に挑戦3 ついに実現!! ーリアクションホイールへの道75ー

現在挑戦中の7重倒立 https://homemadegarbage.com/reactionwheel74// 前回は6重倒立まで確認しました。 7重倒立 6/7クリア pic.twitter.com/62W9bQGo8p — HomeMadeGarbage (...

7重倒立に挑戦2 ーリアクションホイールへの道74ー

前回に引き続き7重倒立に挑戦します。 https://homemadegarbage.com/reactionwheel73/ 前回は新規の7個目の姿勢制御モジュール (SHISEIGYO-1 FOC) を含む上段の6重倒立動作の確認を実施しました。 ここで...

7重倒立に挑戦1 ーリアクションホイールへの道73ー

もはや恒例行事の姿勢制御モジュールの多重倒立挑戦。 今年は7重倒立を目指します。 去年は6重倒立に挑戦しました。 https://homemadegarbage.com/reactionwheel64/ 7重倒立に向けての準備運動 7重倒立実現...

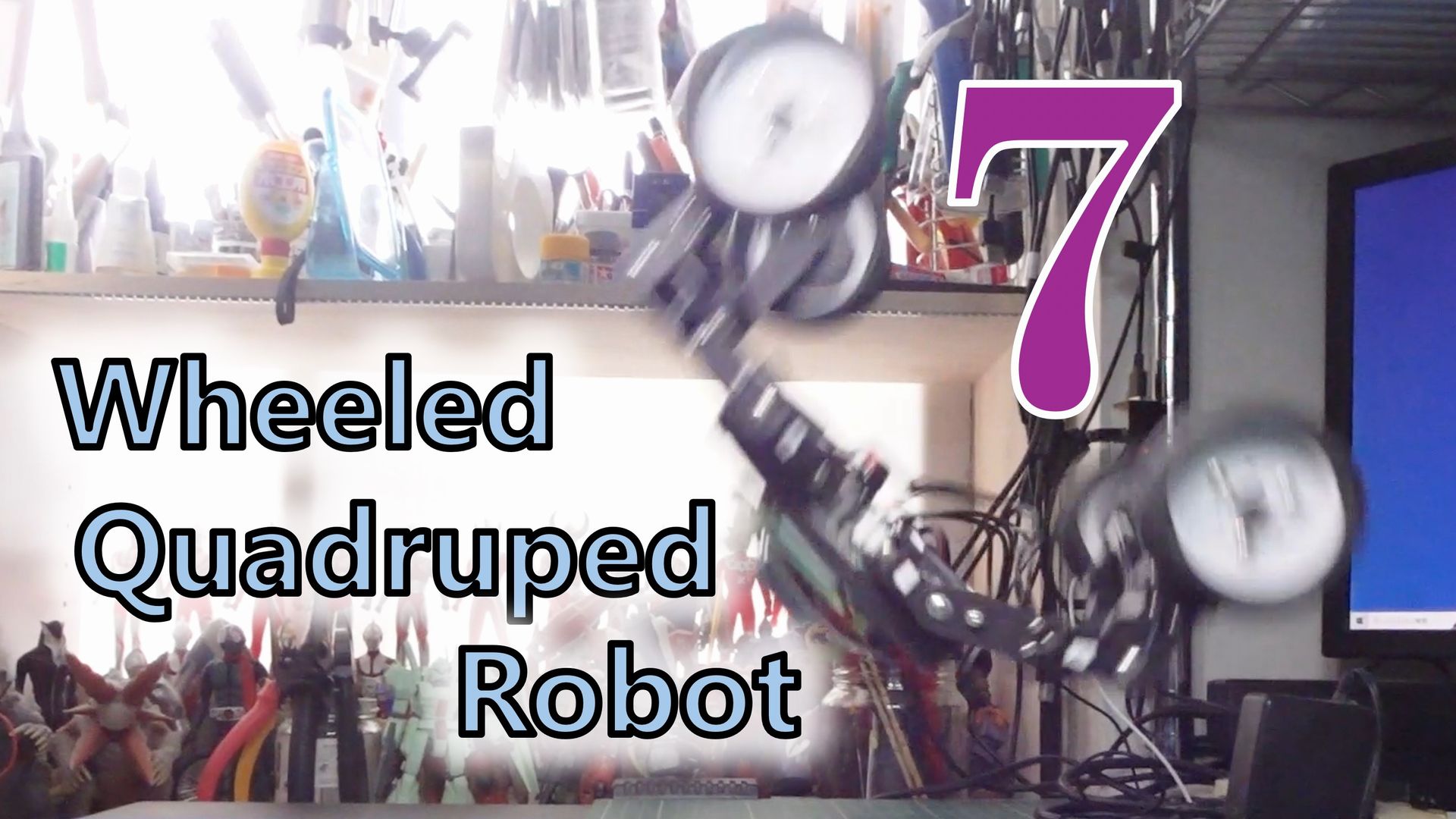

Wheeled Quadruped Robot を作りたい7

HomeMadeGarbage Advent Calendar 2024 |17日目 前回は Wheeled Quadruped Robot の起上り倒立動作の検証を行いました。 https://homemadegarbage.com/wheel-leg09// 涙の最終回...